今天我们推荐的是一条命令快速在本地运行大模型,在GitHub超过22K Star的开源项目:ollama。

ollama是什么?

Ollama 是一个强大的框架,设计用于在 Docker 容器中部署 LLM。Ollama 的主要功能是在 Docker 容器内部署和管理 LLM 的促进者,它使该过程变得非常简单。它帮助用户快速在本地运行大模型,通过简单的安装指令,可以让用户执行一条命令就在本地运行开源大型语言模型,例如 Llama 2。

Ollama 将模型权重、配置和数据捆绑到一个包中,定义成 Modelfile。它优化了设置和配置细节,包括 GPU 使用情况。

安装 ollama

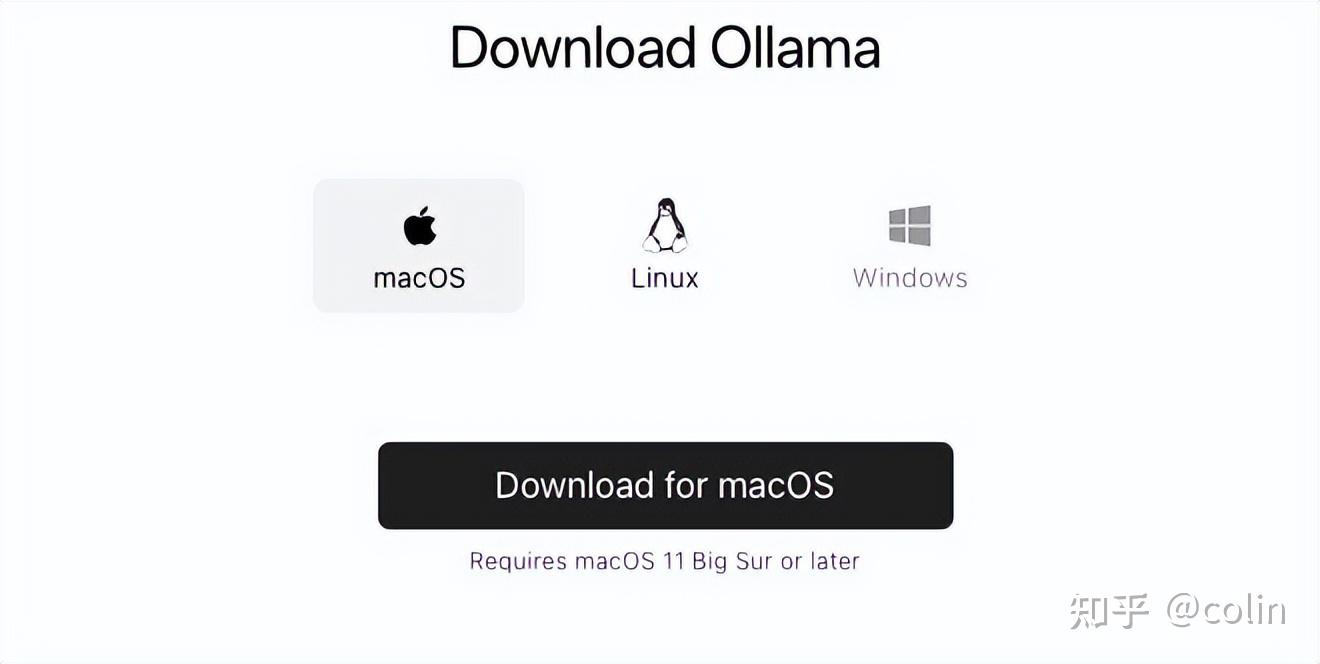

ollama极大的简化了安装的过程,并提供了多种选择。

支持的平台包括:Mac和Linux、windows,并提供了docker 镜像。

直接下载安装包,地址如下:

下载完成后,直接安装即可。

Linux:

Linux同样也提供了一键安装命令:

curl https://ollama.com/install.sh | sh

直接执行命令,可以完成默认安装。

使用 ollama

下一步我们启动一个qwen2.5,只需要执行:

ollama run qwen2.5

之后会自动去pull Llama2的模型,并运行,确实非常的便捷。另外还支持将Ollama作为服务提供到网络环境中。

需要把配置文件改一下:

#1.找到服务的单元文件:

#/etc/systemd/system/目录下

sudo vi /etc/systemd/system/ollama.service

#2.修改配置文件,分为如下2钟情况

#情况1:添加环境变量:

[Service]

Environment="OLLAMA_HOST=0.0.0.0:11434"

#情况2:如果已经有

Environment="PATH=xxx:/root/bin" "OLLAMA_HOST=0.0.0.0:11434"

#3.为了使更改生效,您需要重新加载systemd的配置。使用以下命令:

sudo systemctl daemon-reload

#4.重启服务以应用更改:

sudo systemctl restart ollama 除了Llama2以外 Ollama 还支持其他的开原模型:

https://ollama.com/search

另外还需要注意一下文档中的运行资源说明:

3B模型需要8G内存,7B模型需要16G内存,13B模型需要32G内存。

除了简单的启动模型外,Ollama 可以通过编写 Modelfile 来导入更多的自定义模型,具体的使用方法和配置请自行查阅文档。

Ollama具备灵活的扩展性,它支持和很多工具集成,除了命令行的使用方式,可以通过配合UI界面,简单快速的打造一个类ChatGPT应用。笔者也计划抽空写一期专门的教程,来介绍一个如果快速通过Ollama搭建一个仿ChatGPT。

项目特点

开源:很显然这是首要特点,开源推动者项目的持续发展

开箱即用:一条命令的方式,简化了大量的工作,降低了门槛。

可扩展:可以和很多工具进行集成使用,有更多的玩法

轻量化:不需要太多的资源,Mac就能跑

项目信息

项目名称:Ollama

官方网站:https://ollama.com/

GitHub 链接:https://github.com/jmorganca/ollama

Star 数:22K+

ollama命令

- 启动Ollama服务

ollama serve

- 从模型文件创建模型

ollama create

- 显示模型信息

ollama show

- 运行模型

ollama run 模型名称

- 从注册表中拉去模型

ollama pull 模型名称

- 将模型推送到注册表

ollama push

- 列出模型

ollama list

- 复制模型

ollama cp

- 删除模型

ollama rm 模型名称

- 获取有关Ollama任何命令的帮助信息

ollama help

最后编辑:admin 更新时间:2025-12-21 15:51